最近「バイブコーディング」という言葉を耳にする機会が増えました。これは、AIに自然な言葉で指示を出してコードを書いてもらう開発スタイルのことです。「雰囲気(vibe)で伝えてコーディングする」というのが語源で、たとえば「Reactでログインフォームを作って」と伝えるだけで、AIが実際にコードを生成してくれます。

GitHub Copilotのような補完ツールは以前からありましたが、2025年に入ってからは「エージェント型」と呼ばれる新しいタイプのツールが注目を集めています。エージェント型ツールとは、単にコードを提案するだけでなく、ファイルの作成・編集・実行まで自律的に行ってくれるAIのことです。

その代表格が、OpenAIの「Codex」とAnthropicの「Claude Code」です。筆者は3週間かけて両方のツールを同じプロジェクトで使い比べてみました。この記事では、その経験をもとに、それぞれの特徴や使い分けのポイントをお伝えします。

両ツールの基本的な違い

Codexとは

CodexはChatGPTで知られるOpenAIが提供するツールです。ターミナル(コマンドを入力して操作する画面)で動作し、プロジェクト内のファイルを読み書きしたり、テストを実行したりできます。

特徴的なのは、その「自律性」です。指示を出すと、あまり確認を求めずにどんどん作業を進めてくれます。また、Codex自体がオープンソース(誰でもソースコードを見たり改良したりできる形式)で公開されているため、カスタマイズしやすいという利点もあります。

Claude Codeとは

Claude CodeはAnthropicが提供するツールです。同じくターミナルで動作しますが、Codexとは対照的に「慎重さ」が際立っています。

何か作業を始める前に、まず「こういう手順で進めますがよろしいですか?」と計画を提示してくれます。この「プランモード」と呼ばれる機能により、AIが何をしようとしているのかを事前に確認できるため、意図しない変更を防ぎやすいです。

設計思想の違い

両者の違いは、それぞれの会社の考え方を反映しています。

Codexは「まず便利さを提供したい」というスタンスです。初期設定では、プロジェクト内のファイル操作やコマンド実行は確認なしで自動実行されます。危険な操作のときだけ確認が入る仕組みです。

一方、Claude Codeは「安全性を最優先」という姿勢です。初期設定では読み取り専用モードになっており、ファイルの変更やコマンドの実行には都度許可が必要です。ただし、「サンドボックス」という機能を使えば、あらかじめ許可した範囲内では自由に動けるよう設定できます。

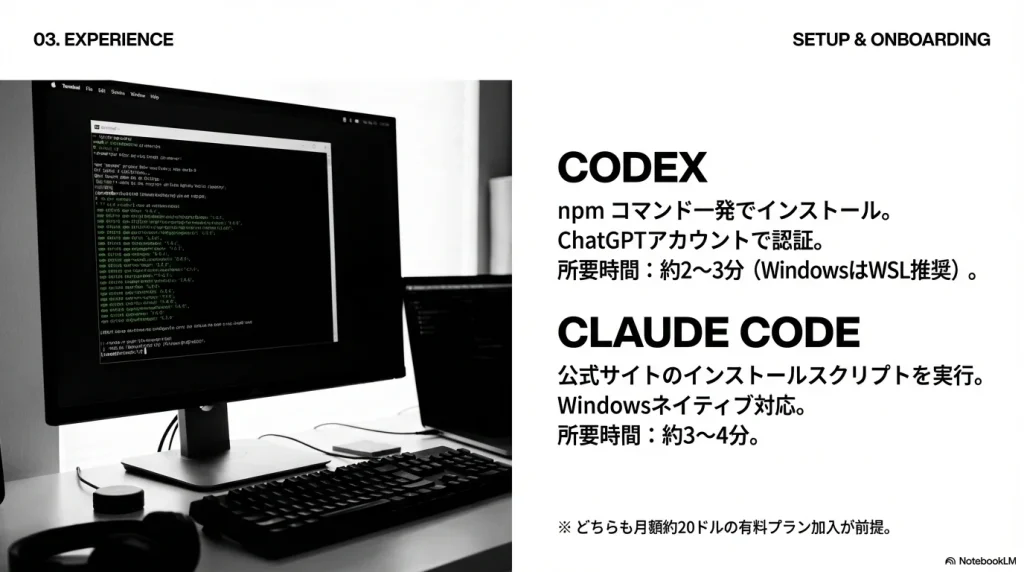

セットアップはどちらも簡単

両ツールとも、インストールから使い始めるまでの手順は非常にシンプルです。

Codexのセットアップ

Codexの場合は、npmコマンド一発でインストールできます。その後、ChatGPTアカウントで認証すれば完了です。筆者の環境では約2〜3分で使える状態になりました。ただし、WindowsではWSL(Windows Subsystem for Linux)上での利用が推奨されている点には注意が必要です。

Codexのセットアップ手順

npm を使う場合(推奨)

npm install -g @openai/codexHomebrew を使う場合(macOS/Linux)

brew install openai-codexインストール後の認証

codex初回実行時にブラウザが開き、ChatGPTアカウントでログインして認証します。

Claude Codeのセットアップ

Claude Codeの場合は、公式サイトのインストールスクリプトを実行するだけです。こちらはWindowsにもネイティブ対応しているため、より幅広い環境で使えます。インストールから初回起動まで約3〜4分でした。

Claude Codeのセットアップ手順

macOS / Linux

curl -fsSL https://claude.ai/install.shHomebrew を使う場合(macOS)

brew install --cask claude-codeWindows(Winget)

winget install Anthropic.ClaudeCodeインストール後の認証

claude初回実行時にブラウザが開き、Claudeアカウントでログインして認証します。

どちらも有料プラン(月額約20ドル)への加入が前提となりますが、セットアップ自体でつまずくことはほとんどないでしょう。

12のユースケースで徹底比較

ユースケース1:新規プロジェクトの雛形作成

タスク内容は「Next.js+TypeScript+Tailwind CSSで新規プロジェクトを作成して」というものです。環境構築は開発の最初に必ず行う作業ですが、設定項目が多く初心者にはハードルが高い部分でもあります。

Codexは指示以上の作業を自発的に行いました。基本的なプロジェクト構成に加えて、ESLintやPrettierの設定ファイルまで自動生成してくれたのです。「コード品質チェックのためESLintを設定します」と宣言し、.eslintrc.jsonや.prettierrcを追加。最終的に生成されたファイルは45個に及び、VS Codeで開いた時点ですでにLint警告が有効になっている状態でした。所要時間は約4分です。

一方、Claude Codeは「言われたことを過不足なく」実行する印象でした。まずプランモードで「1. Next.jsプロジェクト作成、2. Tailwindセットアップ、3. 型チェック構成(オプション)」と手順を提示し、承認後に実行に移ります。ESLintなどの追加設定は含まれず、生成ファイルは40個程度。所要時間は約6分でした。

ユースケース2:既存コードのリファクタリング

タスク内容は「200行を超える長い関数を分割して、可読性を上げて」というものです。リファクタリングはAIにとって判断の余地が大きい作業であり、どこまで納得できる品質に仕上げてくれるかが見どころでした。

Codexは黙々と作業を進めるタイプです。コード全体を解析した後、何の前置きもなくファイルの書き換えを開始しました。差分がリアルタイムで表示され、巨大な関数が4つの小さな関数に分割されていきます。完了後は「Refactoring complete. All tests passing」とだけ報告し、変更理由の説明はありませんでした。

対照的に、Claude Codeは変更の意図を逐一説明してくれました。「この関数は複数の責務を持っているので、データ取得・整形・検証・保存に分けます」と方針を述べてから作業開始。編集中も「fetchData関数を新規作成」と都度コメントし、完了後にはJSDoc形式のコメントまで自動生成されていました。

ユースケース3:バグ修正の依頼

タスク内容は、エラーログを提示して「このバグを直して」と依頼するものです。Null参照エラーのスタックトレースを渡し、AIがどのように原因を特定して修正するかを観察しました。

Codexは即座にコードを修正し、自律的に試行錯誤しました。エラー箇所を特定してNullチェックを追加した後、npm testを自動実行。しかし同じエラーが再発したため、「まだ直っていないようです。別の原因を調べます」とログに出力し、根本原因(データ型の不一致)を突き止めて再修正。最終的に全テストがパスするまで、人間の介入なしで完了しました。

Claude Codeはまず仮説を立てるアプローチを取りました。「可能性1:関数に想定外のnullが渡っている」「可能性2:プロパティが初期化されていない」と複数の原因候補を示し、「ログを見る限り可能性2が高そうです」と絞り込んでから修正に着手。2回目の修正に入る際には「追加の修正が必要ですが、続けますか?」と確認を求めてきました。

ユースケース4:API連携機能の新規実装

タスク内容は「決済サービスStripeのAPIを使って支払い機能を追加して」というものです。外部APIとの連携では、セキュリティ面で安全な実装になっているかも重要なチェックポイントでした。

Codexはプロジェクト全体を俯瞰した実装を行いました。Web検索機能でStripeのAPIドキュメントを参照し、stripeパッケージのインストールから初期化コード、決済処理関数の作成まで一気に進めます。特筆すべきは、APIキーをハードコーディングせず環境変数から読み込む形で実装してくれた点です。さらに.env.exampleファイルやREADMEにも「Stripe APIキーを環境変数に設定してください」と補足を追記していました。

Claude Codeはセキュリティ意識の高さが際立ちました。実装自体はCodexと同等でしたが、完了後に「Webhook検証を導入しないと不正なリクエストを防げません」と警告し、署名検証の対策コードまで提案してきたのです。環境変数未設定時の警告ログ出力など、ドキュメントには載っていない工夫も盛り込まれていました。

ユースケース5:テストコード生成

タスク内容は「この関数のユニットテストをJestで書いて」というものです。AIが既存コードの仕様を正しく理解し、網羅的なテストを生成できるかを検証しました。

Codexはシンプルで実用的なテストを生成しました。関数の仕様をコメントで列挙し、それぞれをテストケースとして実装。正の整数、負の数、境界条件などを考慮しつつ、不明な仕様点(空配列時の動作)については「// TODO: 空配列時の期待動作は仕様次第」とコメントで残していました。生成後は自らnpm testを実行し、全ケースがグリーンになったことを確認。必要十分で冗長さのないテストという印象です。

Claude Codeは教育的で包括的なテストを生成しました。各テストケースに「// 入力: 正の整数のリスト、出力: 平均値」という説明文を添え、expectの直前にも「// 結果が3.5であることを期待(7/2=3.5)」と手計算の根拠を書き込んでいます。空配列ケースもテストに含め、失敗すると「関数側を修正するべきかもしれません」と提案までしてきました。

ユースケース6:README・ドキュメント生成

タスク内容は「このプロジェクトのREADMEを日本語で作成して」というものです。AIがコード全体を読み取り、適切なドキュメントを生成できるか、特に日本語の自然さに注目しました。

Codexは簡潔で標準的なREADMEを生成しました。概要、セットアップ方法、起動方法、テスト方法といった基本セクションを含み、内容に過不足はありません。ただし、「本プロジェクトは〇〇であるWebアプリケーションです」のようにやや直訳調で硬い表現が目立ちました。箇条書きの文末処理(です・ます)が揃っていない部分もあり、軽い推敲が必要という印象です。

Claude Codeは非常に流暢な日本語でREADMEを生成しました。「まずNode.jsをインストールしてください(バージョン16以上を推奨)」といった自然な言い回しで、読み手への配慮を感じます。使い方の例やフォルダ構成の説明まで含まれ、そのまま公開しても違和感のないレベルでした。ただし情報量が多く、300行近いMarkdownになったため、簡潔さを求める場合は調整が必要です。

ユースケース7:コードレビュー依頼

タスク内容は「このプルリクエストの変更点をレビューして、問題があれば指摘して」というものです。複数ファイルの差分を渡し、AIがどのような指摘や提案を出すかを比較しました。

Codexは的確だが簡潔なレビューを返してきました。「入力値のバリデーションが追加されていますが、負数の場合の扱いが網羅されていない可能性があります」「この変更でモバイル表示が崩れる懸念があります」といった指摘は一点につき1〜2文で済ませ、トーンはフラット。褒めることも強く否定することもなく、事実ベースのコメントに終始しました。

Claude Codeは人間味のある優しいレビューを返してきました。「全体的に良い改善だと思います」と前置きしてから細かい指摘に入り、「〜すると良いでしょう」「〜してみてはどうでしょうか?」という提案ベースの表現を使います。テストをちゃんと書いていることなどポジティブなフィードバックも含まれており、最後は「細かな点だけコメントしました」と締めくくっていました。

ユースケース8:パフォーマンス改善

タスク内容は「このコードの実行速度を改善して」というものです。ネストの深いループを含む処理を渡し、AIがボトルネックを見抜いて適切な改善案を出せるかを検証しました。

Codexはズバリ最適解を即実装しました。コードを読むとすぐに「このループはO(n^2)なのでデータ量次第でボトルネックです」と指摘し、ハッシュマップを使った検索に置き換える最適化を実施。さらに驚いたのは、自発的にベンチマークを実行した点です。Before/Afterで100万要素の配列に対して処理時間を計測し、「最適化前: 2.31秒、最適化後: 0.15秒」とレポートしてくれました。

Claude Codeは選択肢を検討してから実装に移りました。「1. ハッシュテーブル導入」「2. 並列処理で分割」「3. ソートして二分探索」と複数案を示し、「データサイズやメモリトレードオフを考えると、今回は1が良さそうです」と方針決定。実装内容はCodexと同じでしたが、ベンチマークは推定値の提示に留まり、実測はしていませんでした。

ユースケース9:複数ファイルにまたがる大規模変更

タスク内容は「認証方式をJWTからセッションIDベースに変更して」というものです。複数のモジュールに手を入れる必要があり、変更漏れが許されないシナリオでした。

Codexは素早く大胆に変更を完遂しました。まずプロジェクト中の「JWT」を含む箇所をgrepで検索し、5ファイルに該当があることを確認。それらを順次開いて編集を進め、「必要な箇所は全て書き換えました」と報告。ただし、npm run buildを実行したところ型エラーが1件発生し、JWTトークンの型定義が残っていたことが判明しました。Codexは即座にこれを検出して削除し、最終的にはテストもパスしました。

Claude Codeは隅々まで気を配る作業ぶりでした。プランモードで変更方針をまとめ、ファイルごとに一つずつ確認を取りながら進めます。Codexが見落とした型定義についても、Plan段階で触れていたため漏れはありませんでした。さらに、API仕様書やREADMEの記述も忘れずに更新してくれた点が印象的です。

ユースケース10:デバッグの壁打ち相手

タスク内容は「なぜかこのコードが動かない。一緒に原因を探って」というものです。エラーは出ないが期待通りの結果にならないロジックについて、AIと対話しながら原因究明を試みました。

Codexは一発で原因を当てました。コードを読んだ後、「ここの条件分岐が期待と逆では?」とずばり指摘。実際、バグはif文の条件ミスだったので、Codexの言う通りでした。「修正しますか?」と聞いてきたので依頼すると、該当箇所を修正して完了。対話というより即解答という印象で、推論過程の共有はありませんでした。

Claude Codeは「一緒に調べましょう」というスタンスでした。「どんな動作を期待していて、実際どうなっていますか?」と質問し、状況説明を受けてから該当箇所を重点的にチェック。「比較関数が正しくないかも」「データにnullが混じっているかも」と複数の仮説を提案し、一つずつ検証していきます。約5往復のやり取りを経て原因にたどり着き、まさにペアプログラミングでデバッグしている感覚でした。

ユースケース11:学習目的での質問

タスク内容は「このコードの仕組みを初心者にもわかるように説明して」というものです。難解な再帰アルゴリズムを題材に、AIの解説のわかりやすさを比較しました。

Codexは正確だが教科書的な説明を返してきました。コードを上から読んで、「まず関数fooが定義されています。引数barを受け取ります」という風に流れを文章化。専門用語も使われており、「再帰とは、自分自身を呼び出すことです」程度の補足に留まりました。例え話や図解はなく、中級者向け解説というレベル感です。

Claude Codeは驚くほど砕けた口調で説明してくれました。「このコード、一見難しそうですよね。でも大丈夫、一緒に見ていきましょう」という書き出しから始まり、比喩やたとえ話を多用。「この関数は自分自身を呼んでいます。まるで鏡に映った自分にもう一度問いかけるような感じです」「小さな問題を解いて、それを組み合わせて全体を解くパズルみたいですね」といった表現が出てきました。ステップごとに区切って説明し、専門用語には必ず注釈を入れていました。

ユースケース12:Git操作の自動化

タスク内容は「変更をコミットして、feature/loginブランチにプッシュして」というものです。AIが適切なコミットメッセージを書けるか、意図しないプッシュをしないかを検証しました。

Codexはデフォルトで自動実行でした。「先に変更点を確認しますか?」と提案してきましたが、不要と伝えると即座にgit commitを実行。コミットメッセージは「Add login feature: implement XYZ」に続けて箇条書きで変更点が入る形式で、内容自体は適切でした。続けて何の確認もなくgit pushまで実行し、「Git push completed.」とだけ報告して終了。スピーディですが、万一remote先を間違えていたらと思うと少しヒヤリとします。

Claude Codeは確認を取りながら進めました。「コミットメッセージはどのようにしましょうか?」と質問し、「適当に考えて」と返すと「feat: ログイン機能の追加」から始まるConventional Commits形式のメッセージを提案。プッシュに関しては**「リモートにプッシュしますね。よろしいですか?」と確認**を求め、許可後に-uオプション付きで実行しました。さらに「Pull Requestを作成しますか?」と尋ねてくるなど、開発フロー全体を見据えた提案がありました。

比較結果のまとめ

12のユースケースを通じて感じた傾向を表にまとめます。

| ユースケース | Codex | Claude Code | 備考 |

|---|---|---|---|

| 新規プロジェクト作成 | ◎ | ◯ | Codexは追加設定まで自動化 |

| リファクタリング | ◯ | ◎ | Claudeは変更理由を詳しく説明 |

| バグ修正 | ◯ | ◯ | どちらも実力は同等 |

| テストコード生成 | ◎ | ◯ | Codexはシンプルで実用的 |

| ドキュメント生成 | ◯ | ◎ | Claudeの日本語が自然 |

| コードレビュー | ◯ | ◎ | Claudeは指摘が柔らかい |

| パフォーマンス改善 | ◎ | ◯ | Codexはベンチマークまで実行 |

| 大規模な変更 | ◯ | ◎ | Claudeは変更漏れが少ない |

| デバッグの相談 | ◯ | ◯ | スタイルの好み次第 |

| 初心者への説明 | △ | ◎ | Claudeは比喩を使って解説 |

| Git操作 | ◯ | ◯ | Claudeはコミットメッセージが丁寧 |

料金とコストパフォーマンス

両ツールとも基本は月額サブスクリプション制です。

CodexはChatGPT Plusプラン(月額20ドル)に含まれています。ChatGPTの各種機能も使えることを考えると、コストパフォーマンスは良好です。筆者が3週間ヘビーに使っても、追加料金は発生しませんでした。

Claude CodeはClaude Proプラン(月額約20ドル)で利用可能です。ただし、長時間連続で使用すると「使用量が多いので休憩してください」という制限に当たることがありました。制限なく使いたい場合はMaxプラン(月額100ドル〜)へのアップグレードが必要です。

個人で軽く使う程度なら、どちらも月20ドルで収まるでしょう。ただし、毎日何時間も使うようなヘビーユーザーの場合、Codexの方がコスト面で有利になる傾向があります。

セキュリティについて

どちらのツールも、入力したコードはクラウド上のAIモデルに送信されます。これは認識しておくべき重要なポイントです。

ただし、有料プランではユーザーのデータをAIの学習に使わないというポリシーが明示されています。企業での利用を検討する場合は、社内規定との照らし合わせが必要になるでしょう。

セキュリティの観点では、Claude Codeのサンドボックス機能が興味深いです。「このディレクトリ内だけ操作を許可する」といった制限をかけられるため、意図しないファイル操作のリスクを軽減できます。

日本語での使い勝手

日本語で指示を出す場合、両者とも問題なく理解してくれます。「この変数おかしくない?」といった曖昧な表現でも、文脈から意図を汲み取って対応してくれました。

ただし、出力される日本語の質には差があります。Claude Codeの方が自然で読みやすい日本語を生成する傾向が顕著でした。コメントやドキュメントを日本語で書きたい場合は、この点を考慮に入れる価値があります。

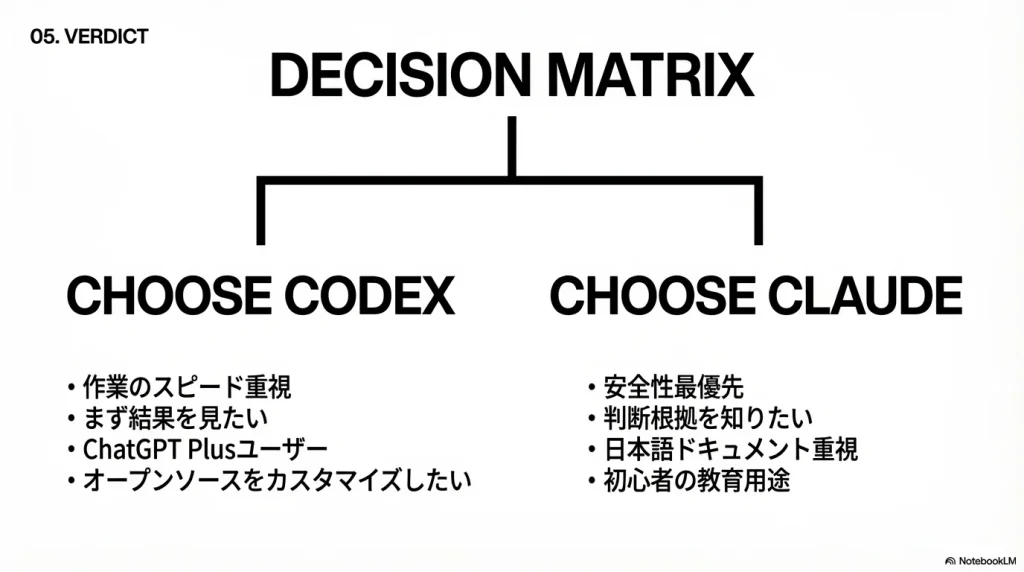

どちらを選ぶべきか

Codexが向いている人

- 作業のスピードを重視したい

- 細かい確認より、まず結果を見たい

- すでにChatGPT Plusを利用している

- オープンソースをカスタマイズしたい

Claude Codeが向いている人

- 安全性を最優先したい

- AIの判断根拠を詳しく知りたい

- 日本語のドキュメントを多く扱う

- 初心者の教育用途にも使いたい

筆者の結論

正直なところ、筆者はCodex派です。「まず動くものを作って、後から整える」という開発スタイルには、Codexのスピード感がよく合います。

ただし、これは完全に好みの問題です。大規模なプロジェクトを預かるエンジニアに聞くと、「安心して任せられるのはClaude Code」という意見もありました。

迷っているなら、まずChatGPT Plusに加入してCodexを試し、物足りなければClaude Codeも検討する、という順序がおすすめです。どちらも月単位で解約できるので、実際に触ってみてから判断するのが一番確実でしょう。

おわりに

AIコーディングツールの進化は目覚ましく、この1年だけでも大きな変化がありました。CodexとClaude Codeはその最前線にいるツールであり、どちらを選んでも開発効率の向上は間違いなく期待できます。

重要なのは、ツールの特性を理解した上で、自分の開発スタイルに合った使い方を見つけることです。「AIに任せられるところは任せ、人間はより創造的な部分に集中する」そんな未来が、すでに手の届くところまで来ています。

コメント